Comment un rat avec un phallus gigantesque a remis de l'huile sur la crise de la méthode scientifique

La Publication

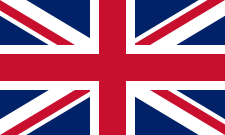

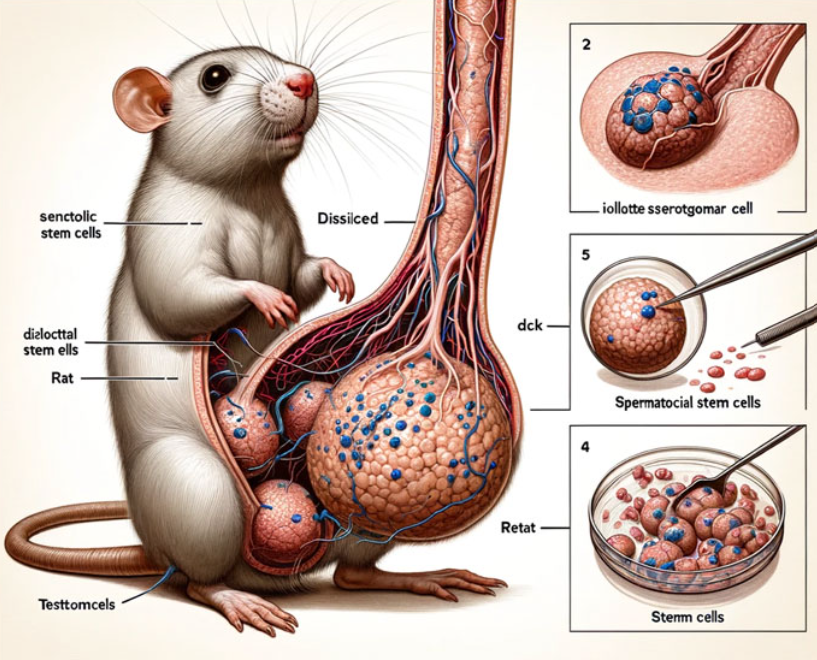

Le 13 février 2024, dans un silence caractéristique de la publication d’un article de recherche, “Cellular functions of spermatogonial stem cells in relation to JAK/STAT signaling pathway” est publiée dans la revue Frontiers. La surprise arrive seulement deux jours après quand ce post commence à se diffuser dans la bulle de la recherche en biologie : un rat avec un pénis extrêmement grand.

Si dans un premier temps, on se dit seulement que c’est de mauvais goût mais que, fondamentalement, c’est pas un problème, on remarque en essayant de lire cet horrible schéma la présence de mots comme “dck” ou “iollotte” ou “sserotgomar”. Hé oui! ces schémas ont bien été générés par Midjourney.

Un rat pareil doit se remarquer, non ?

L’arrivée des IAs génératives bouscule quelque peu les revues qui publient les résultats. Si certaines comme Nature ont rapidement interdit l’usage de l’IA, d’autres ont décidé de laisser l’éthique et la liberté aux auteurs des articles. Vous l’aurez compris, Frontiers fait partie de la seconde catégorie. En effet, tant qu’il est explicitement mentionné que l’image a été généré par une intelligence artificielle, un auteur peut décider de l’utiliser comme schéma.

Malgré tout, on parle d’un rat avec un 30cm entre les pattes, les relecteurs ont bien dû le remarquer. Manifestement, il l’ont bien vul’énorme rateau. Interrogé par Vice, l’un des relecteurs explique qu’il n’a pas pour rôle de valider la qualité scientifique de tels schémas. D’après ce même relecteur, c’est la politique de l’éditeur qui fait office de loi. La loi étant résumée à on compte sur vous pour être intègre, les amigos.

Revues prédatrices, subterfuges, crise méthodique et LLM

La plus grosse inquiétude concernant l’émergence et la progression des IAs génératives est leur capacité à très bien travestir des développements humains. Des dizaines de milliers d’articles ont déjà été rejeté de la revue Nature pour recours à des IAs génératives. La question de savoir si on a affaire à du bullshit LLM ou à un véritable développement ne devient plus si évident et les outils actuels de détection sont encore imparfaits. Alors prenez des relecteurs qui sont pas spécialement très bien rémunérés ou mis en avant par une revue scientifique pas tout à fait rigoureuse, ils vont pas avoir envie de chercher la bête : l’intégrité se brise à un moment.

Mais le pire !

Si j’avais vu les premiers schémas un peu en diagonale, je n’aurais rien vu. De manière identique, si je lis leur article sur le rat au gros pénis, je ne serais pas certain de la validité de ce qui est raconté. D’ailleurs, si vous mettez leur article dans différents outils de détection de LLM, on a du positif. Bien sûr, c’est imparfait mais il y a une chance qu’un texte généré par une LLM soit parfaitement passé par une relecture.

Et alors ? Tant que c’est valide, c’est bon.

Fondamentalement, qu’une IA fasse du bullshit ou bien une sorte de resucée de travaux des dits-auteurs, ce n’est pas mauvais puisqu’il doit exister une vérification permettant d’assurer de la validité du bullshit LLM.

Néanmoins, outre l’intégrité d’un chercheur - on suppose qu’il mentionnera son LLM préféré comme co-auteur - , on oublie l’existence de ce qu’on appelle une revue prédatrice. Ces revues ne pratiquent très généralement pas la relecture par les pairs. Bien souvent connu par les chercheurs, c’est moins le cas d’un non-initié. (vous me direz que ces revues n’étaient déjà pas à lire mais j’insiste un peu sur le danger)

Mais le pire 2 !

Quand on pense à la recherche, on pense naturellement, nous, ingénieurs dans l’informatique et les mathématiques, à des disciplines disons solides qui ne reposent que sur des fondements théoriques qui peuvent être factuellement facilement démontés. Excepté des hyperdocteurs qui démontrent Syracuse, nous n’avons pas d’équivalent de rat à gros phallus (quoique, rappelons-nous le fameux pi = 3,2). Cependant, dans les sciences sociales et dans les sciences du vivant (et même dans des domaines de la physique plus généralement), de nombreux résultats de ces domaines n’arrivent pas à être retrouvées, notamment pour les expériences. Rappelez-vous, vos plus grands moments de TPE ou TIPE à falsifier vos résultats ou bien à ignorer vos incertitudes, hé bien ça continue après encore (jusqu’à très haut). Dans ce brouhaha de non-reproductibilité, - je n’en ai pas parlé jusque-là - de sensationnalisme (très sensationnel un rat à grosse b) et d’intérêt économique, un bullshiter pro comme GPT, il peut se faufiler comme personne.

Final Shot (pas du rat n’ayez pas peur)

Il y a une nécessité à contrôler fermement l’utilisation des LLM dans la recherche. Ne serait-ce que pour des questions de comment ces LLM sont construits, pour les plus connus. Sur une quantité de données assez faibles pour un sujet, ils peuvent très facilement halluciner. La recherche, c’est parfois avoir un article qui parle d’une partie des testicules d’un rat, peut-on avoir confiance sur les données de GPT (par exemple) et qu’il va pas commencer à bullshiter n’importe comment ? Après, interdire n’est pas obligatoire, GPT (ou plus récemment Mistral) est par exemple merveilleux pour faire des traductions d’articles, voire des réécritures en utilisant des notations plus parlantes.

Cet article n’a pas été relu par un pair.